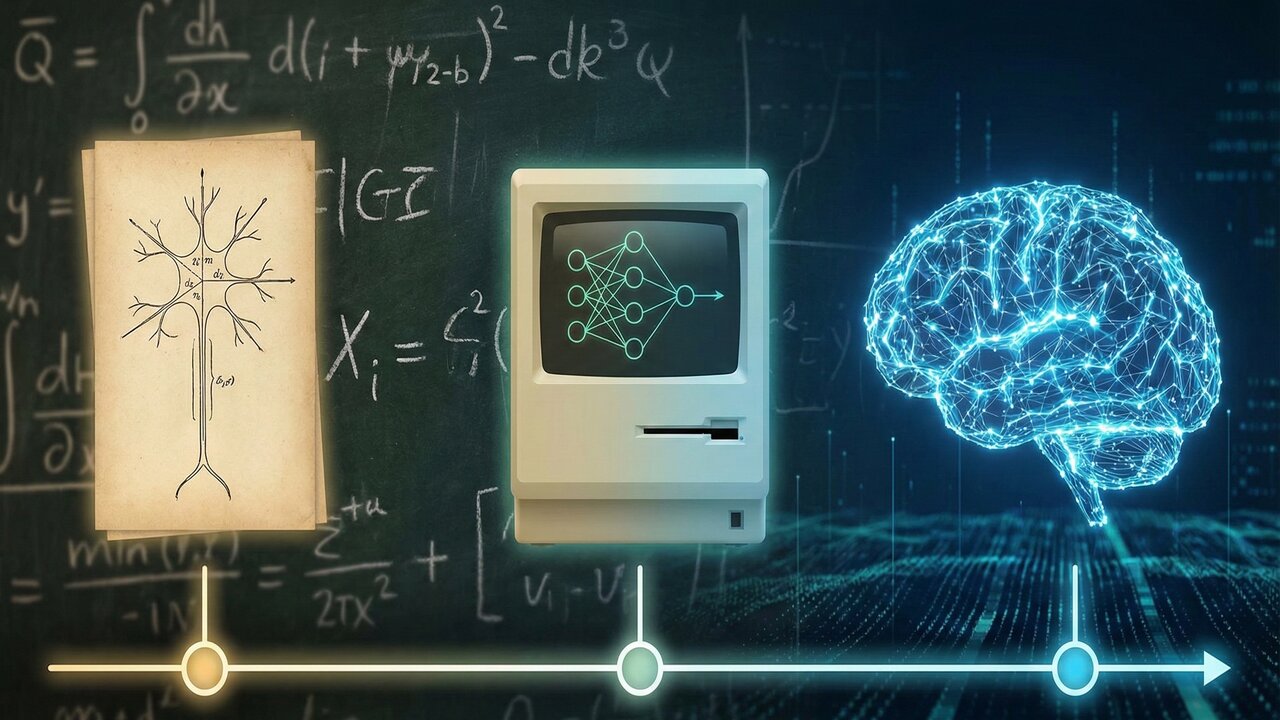

A história das redes neurais é uma jornada fascinante que começou décadas antes do surgimento do ChatGPT. De modelos matemáticos teóricos em 1943 ao Deep Learning moderno, o desenvolvimento da IA é fruto do trabalho de pioneiros muitas vezes esquecidos pela ciência.

Qual a origem da história das redes neurais e quem foram os pioneiros?

A história das redes neurais começou em 1943 com Walter Pitts e Warren McCulloch, que criaram o primeiro modelo matemático de um neurônio artificial. Eles provaram que uma rede desses neurônios poderia executar operações lógicas, estabelecendo a base da computação biológica.

Em 1958, Frank Rosenblatt avançou a ideia com o Perceptron Mark I, uma máquina capaz de aprender a reconhecer padrões simples através de “pesos” ajustáveis. Foi a primeira vez que uma máquina física demonstrou a capacidade de aprender com os próprios erros.

Por que a inteligência artificial enfrentou um “inverno” de décadas?

Apesar do otimismo inicial, a história das redes neurais sofreu um duro golpe em 1969, quando Marvin Minsky publicou um livro detalhando as limitações dos Perceptrons. Ele provou que eles não conseguiam resolver problemas não-lineares simples, como a porta lógica XOR.

Para mergulhar na ideia matemática que tornou possível a revolução das IAs modernas, selecionamos o conteúdo do canal infinitamente. No vídeo a seguir, o narrador detalha a história das redes neurais, desde os conceitos inspirados no cérebro humano até as máquinas que aprendem sozinhas hoje:

Essa crítica paralisou o financiamento e o interesse acadêmico pela área por décadas, período conhecido como o “Inverno da IA”. O foco da computação migrou para sistemas baseados em regras rígidas, deixando as redes neurais no ostracismo até novas descobertas matemáticas surgirem.

Como o método de Gauss e o Gradiente ajudaram no treino da IA?

A solução para treinar redes profundas veio de métodos matemáticos antigos, como o Gradiente Descendente. Esse conceito busca encontrar a direção que reduz o erro de forma mais rápida em uma curva, um princípio ligado aos estudos de Carl Friedrich Gauss em 1801.

Para que você compreenda as fases de evolução da inteligência artificial, preparamos uma comparação entre as eras das redes neurais:

| Era da IA | Tecnologia Principal | Característica de Aprendizado |

| Pioneira (1943) | Neurônio de Pitts-McCulloch | Lógica matemática binária pura |

| Perceptron (1958) | Mark I de Rosenblatt | Ajuste de pesos e reconhecimento de padrões |

| Deep Learning (80s-Hoje) | Backpropagation | Redes multicamadas e ajuste retroativo de erros |

O que é o algoritmo Backpropagation e por que ele é crucial?

O Backpropagation (retroproporgação) é o algoritmo fundamental que permitiu o sucesso do Deep Learning. Ele calcula o erro na saída da rede e volta camada por camada, ajustando cada conexão proporcionalmente à sua contribuição para a falha, permitindo o treino de redes complexas.

Embora inventado nos anos 60 por Henry J. Kelley, ele só foi popularizado nos anos 80, permitindo o boom atual da IA generativa. Abaixo, listamos os elementos técnicos que tornam o aprendizado de máquina possível hoje, segundo diretrizes da UNESCO:

-

Funções de Ativação: Decidem se um neurônio deve ser “disparado” ou não.

-

Pesos e Vieses: Parâmetros que a máquina ajusta para encontrar o acerto.

-

Big Data: A imensa quantidade de dados necessária para alimentar o treino.

Qual o futuro da IA com base na história das redes neurais?

O avanço atual é sustentado por décadas de teoria que agora encontram poder de processamento suficiente para serem executadas. O Governo Federal brasileiro já desenvolve estratégias para o uso ético e produtivo da inteligência artificial no país.

Entender a história das redes neurais é perceber que a IA não é mágica, mas matemática aplicada à imitação da biologia. O futuro promete redes ainda mais eficientes e integradas ao cotidiano, transformando desde a medicina até a forma como interagimos com a tecnologia digital.